首先安装Dify:

安装docker-compose:

sudo curl -L "https://github.com/docker/compose/releases/download/v2.20.2/docker-compose-$(uname -s)-$(uname -m)" -o /usr/local/bin/docker-compose

#连接超时用下面这句

#sudo wget -L "https://github.com/docker/compose/releases/download/v2.20.2/docker-compose-$(uname -s)-$(uname -m)" -o /usr/local/bin/docker-compose

sudo chmod +x /usr/local/bin/docker-compose

docker-compose -v

#安装docker

sudo apt install docker.io

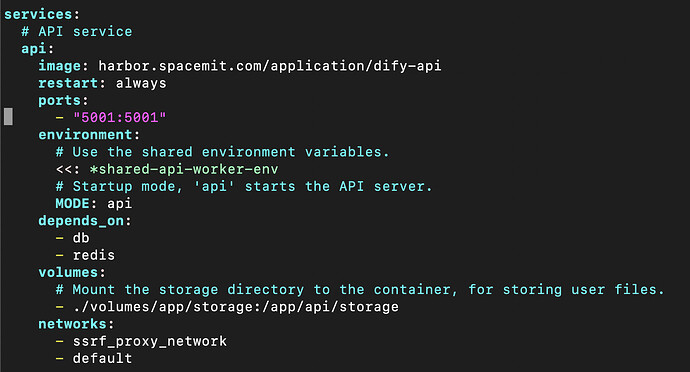

下载dify配置文件

mkdir dify

cd dify

wget https://archive.spacemit.com/spacemit-ai/dify/spacemit-dify.tar.gz

tar -xvzf spacemit-dify.tar.gz

#启动dify

docker-compose up -d

在浏览器输入127.0.0.1/install即可使用。

使用本地大模型Ollama(本项目ollama拥有一个专属docker,无需另起本地Ollama服务):

登录dify后,点击右上角昵称,点击模型供应商,点击ollama,模型名称填入内置的qwen2-quantify大模型,基础URL填入http://ollama:11434,点击确认,即可在Dify上使用本地大模型ollama。

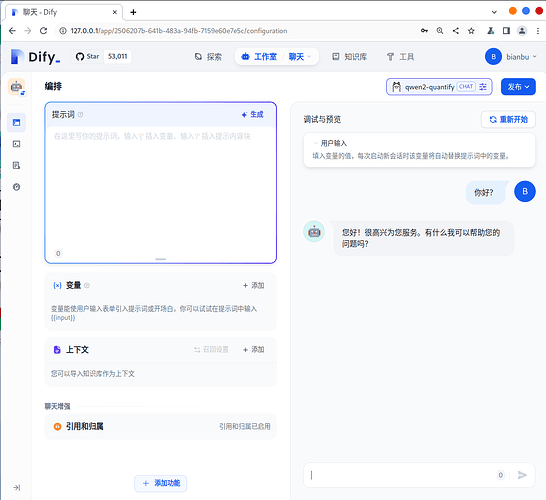

回到主界面,点击创建应用,进入聊天界面,点击发布左边的模型,会出现

ollama的qwen2-quantify模型,选择模型即可进行聊天。